Apple introduit de nouvelles fonctionnalités de sécurité pour les enfants, notamment la numérisation de matériel d’abus sexuel connu dans les photothèques des utilisateurs

Apple a présenté aujourd’hui de nouvelles fonctionnalités de sécurité pour les enfants qui viendront sur ses plates-formes avec des mises à jour logicielles plus tard cette année. La société a déclaré que les fonctionnalités ne seront disponibles aux États-Unis qu’au lancement et seront étendues à d’autres régions au fil du temps.

sécurité des communications

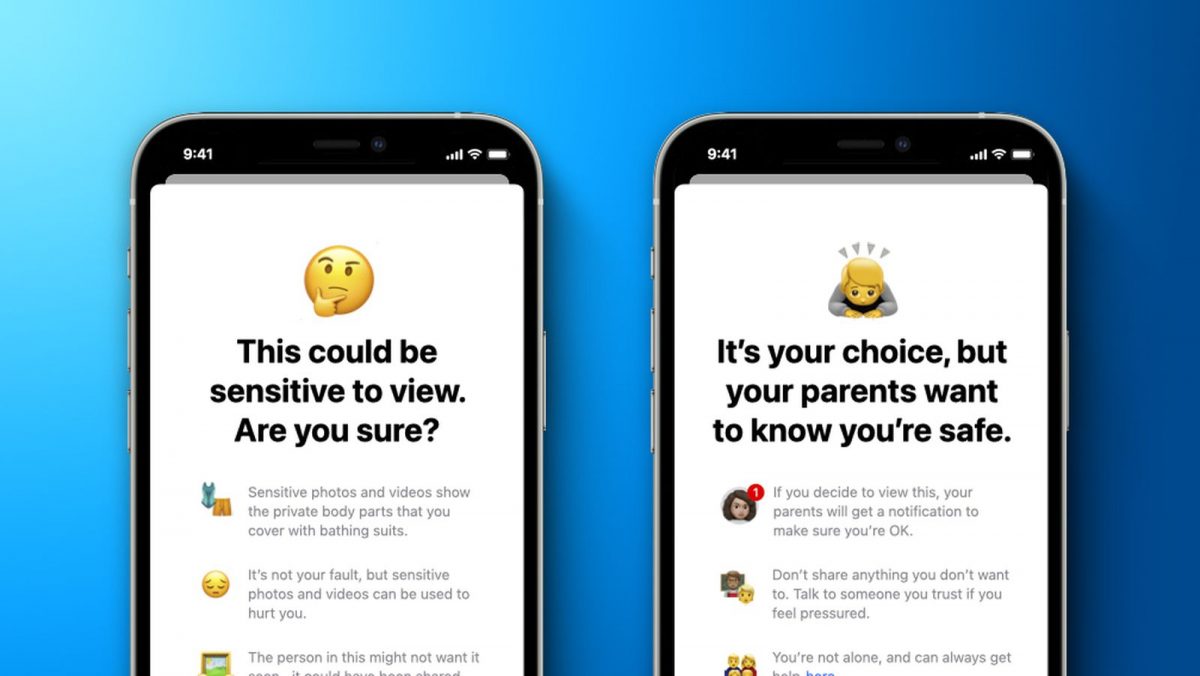

Tout d’abord, l’application de messagerie sur iPhone, iPad et Mac recevra une nouvelle fonctionnalité de sécurité des communications pour alerter les enfants et leurs parents lors de la réception ou de l’envoi de photos sexuellement explicites. Apple a déclaré que l’application de messagerie utiliserait l’apprentissage automatique sur l’appareil pour analyser les pièces jointes d’images, et si une photo s’avère sexuellement explicite, elle sera automatiquement floue et l’enfant sera averti.

Lorsqu’un enfant essaie de voir une photo signalée comme confidentielle dans l’application de messagerie, il est averti que la photo peut contenir des parties du corps privées et peut être dangereuse. Selon l’âge de l’enfant, les parents auront également la possibilité de recevoir une notification si leur enfant continue de voir la photo sensible ou s’ils choisissent d’envoyer une photo sexuellement explicite à un autre contact après avoir été averti.

Apple a déclaré que la nouvelle fonctionnalité de sécurité des communications viendra dans les mises à jour pour iOS 15, iPadOS 15 et macOS Monterey plus tard cette année pour les comptes configurés en tant que familles sur iCloud. Apple a veillé à ce que les conversations iMessage restent protégées par un cryptage de bout en bout, rendant les communications privées illisibles par Apple.

Numérisation de photos à la recherche de matériel pédopornographique (CSAM)

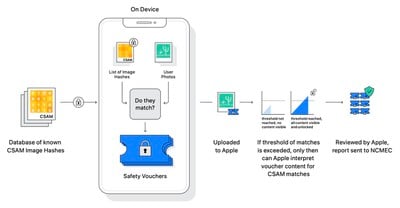

Deuxièmement, à partir de cette année avec iOS 15 et iPadOS 15, Apple sera en mesure de détecter les images connues d’abus sexuels sur enfants (CSAM) stockées dans iCloud Photos, permettant à Apple de signaler de tels événements au National Center for Children Missing and Exploited (NCMEC) , une organisation à but non lucratif qui travaille en collaboration avec les forces de l’ordre américaines.

Apple a déclaré que sa méthode de détection CSAM bien connue est conçue en tenant compte de la confidentialité des utilisateurs. Au lieu de numériser des images dans le cloud, Apple a déclaré que le système effectuerait une comparaison sur l’appareil avec une base de données de hachages d’images CSAM connus fournie par le NCMEC et d’autres organisations de sécurité des enfants. Apple a déclaré qu’il transformerait davantage cette base de données en un ensemble de hachages illisibles qui sont stockés en toute sécurité sur les appareils des utilisateurs.

La technologie de hachage, appelée NeuralHash, analyse une image et la convertit en un numéro unique spécifique à cette image, selon Apple.

« L’objectif principal du hachage est de garantir que des images identiques et visuellement similaires donnent le même hachage, tandis que des images différentes les unes des autres donnent des hachages différents », a déclaré Apple dans un nouveau livre blanc « Protection étendue pour les enfants ». « Par exemple, une image qui a été légèrement recadrée, redimensionnée ou convertie de la couleur au noir et blanc est traitée de la même manière que l’originale et a le même hachage. »

Avant qu’une image ne soit stockée dans iCloud Photos, Apple a déclaré qu’un processus de correspondance sur l’appareil était effectué pour cette image par rapport à l’ensemble illisible de hachages CSAM connus. S’il y a une correspondance, l’appareil crée un bon de sécurité cryptographique. Ce bon est téléchargé sur iCloud Photos avec l’image, et une fois qu’une limite d’envoi non divulguée est dépassée, Apple peut interpréter le contenu des bons pour les envois CSAM. Apple analyse ensuite manuellement chaque rapport pour confirmer une correspondance, désactive le compte iCloud de l’utilisateur et envoie un rapport au NCMEC. Apple ne partage pas sa limite exacte, mais il garantit un « niveau de précision extrêmement élevé » afin que les comptes ne soient pas signalés de manière incorrecte.

Apple a déclaré que sa méthode de détection CSAM bien connue offre des « avantages importants en matière de confidentialité » par rapport aux techniques existantes :

• Ce système est un moyen efficace d’identifier les CSAM connus stockés dans les comptes iCloud Photos, tout en protégeant la confidentialité des utilisateurs.

• Dans le cadre du processus, les utilisateurs ne peuvent également rien apprendre sur l’ensemble d’images CSAM connues qui sont utilisées pour la correspondance. Cela protège le contenu de la base de données d’une utilisation malveillante.

• Le système est très précis, avec un taux d’erreur extrêmement faible de moins d’un compte sur mille milliards par an.

• Le système préserve beaucoup plus la confidentialité que l’analyse basée sur le cloud en ne signalant que les utilisateurs qui ont une collection de CSAM connus stockés dans iCloud Photos.

La technologie sous-jacente au système d’Apple est assez complexe et a publié une note technique plus détaillée.

« La protection élargie des enfants d’Apple change la donne. Avec autant de personnes utilisant des produits Apple, ces nouvelles mesures de sécurité ont le potentiel de sauver des vies pour les enfants qui sont attirés en ligne et dont les images horribles circulent dans le matériel d’abus sexuels d’enfants », a déclaré John Clark, président et chef de la direction du Centre national pour les enfants disparus et exploités. « Au Centre national pour les enfants disparus et exploités, nous savons que ce crime ne peut être combattu que si nous restons déterminés à protéger les enfants. Nous ne pouvons le faire que parce que des partenaires technologiques comme Apple s’expriment et montrent leur dévouement. La réalité est que la vie privée et la protection des enfants peuvent coexister. Nous applaudissons Apple et sommes impatients de travailler ensemble pour faire de ce monde un endroit plus sûr pour les enfants. «

Guide élargi du CSAM sur Siri et la recherche

Troisièmement, Apple a déclaré qu’il étendrait les conseils sur Siri et Spotlight Search sur tous les appareils, en fournissant des ressources supplémentaires pour aider les enfants et les parents à rester en sécurité en ligne et à obtenir de l’aide dans des situations dangereuses. Par exemple, les utilisateurs qui demandent à Siri comment ils peuvent signaler la CSAM ou l’exploitation d’enfants seront dirigés vers des ressources indiquant où et comment déposer un signalement.

Les mises à jour pour Siri et Search arriveront plus tard cette année dans une mise à jour pour iOS 15, iPadOS 15, watchOS 8 et macOS Monterey, selon Apple.

Remarque : En raison de la nature politique ou sociale de la discussion sur ce sujet, le sujet de discussion se trouve dans notre forum Actualités politiques. Tous les membres du forum et les visiteurs du site peuvent lire et suivre le sujet, mais les messages sont limités aux membres du forum avec au moins 100 messages.

Commentaires

Laisser un commentaire