Apple annonce aujourd’hui trois nouveaux efforts qu’il entreprend pour apporter une nouvelle protection pour les enfants à l’iPhone, l’iPad et le Mac. informations actualisées sur les connaissances pour Siri et Research.

Une chose qu’Apple souligne, c’est que son nouveau programme est ambitieux, mais que « protéger les enfants est une responsabilité importante ». Dans cet esprit, Apple affirme que ses efforts » évolueront et s’étendront au fil du temps « .

Table of Contents

messages

La première annonce d’aujourd’hui est une nouvelle fonctionnalité de sécurité des communications dans l’application de messagerie. Apple explique que lorsqu’un enfant faisant partie d’une famille iCloud reçoit ou tente d’envoyer des photos sexuellement explicites, l’enfant verra un message d’avertissement.

Apple explique que lorsqu’un enfant reçoit une image sexuellement explicite, l’image est floue et l’application de messagerie affiche un avertissement indiquant que l’image « peut être sensible ». Si l’enfant appuie sur « Afficher la photo », il verra un message contextuel lui expliquant pourquoi l’image est considérée comme confidentielle.

La fenêtre contextuelle explique que si l’enfant décide de voir l’image, le parent iCloud Family recevra une notification « pour s’assurer que vous allez bien ». La fenêtre contextuelle comprendra également un lien rapide pour recevoir une aide supplémentaire.

De plus, si un enfant essaie de télécharger une image sexuellement explicite, il verra un avertissement similaire. Apple dit que l’enfant sera averti avant l’envoi de la photo et que les parents peuvent recevoir un message si l’enfant décide de l’envoyer, pour les enfants de moins de 13 ans.

Apple explique en outre que Messaging utilise l’apprentissage automatique sur l’appareil pour analyser les images jointes et déterminer si une photo est sexuellement explicite. iMessage reste crypté de bout en bout et Apple n’a accès à aucun des messages. La fonctionnalité sera également facultative.

Apple indique que cette fonctionnalité sera disponible « plus tard cette année pour les comptes configurés en tant que familles sur iCloud » dans les mises à jour d’iOS 15, iPadOS 15 et macOS Monterey. La ressource sera disponible aux États-Unis pour commencer.

Détection CSAM

Deuxièmement, et peut-être le plus notable, Apple annonce de nouvelles mesures pour lutter contre la propagation du matériel pédopornographique, ou CSAM. Apple explique que CSAM fait référence au contenu qui décrit des activités sexuellement explicites impliquant un enfant.

Cette fonctionnalité, qui a été divulguée en partie aujourd’hui, permettra à Apple de détecter les images CSAM connues lorsqu’elles sont stockées dans iCloud Photos. Apple peut ensuite signaler les incidents de CSAM au National Center for Missing and Exploited Children, une entité qui agit comme une agence de signalement complète pour CSAM et travaille en étroite collaboration avec les autorités chargées de l’application des lois.

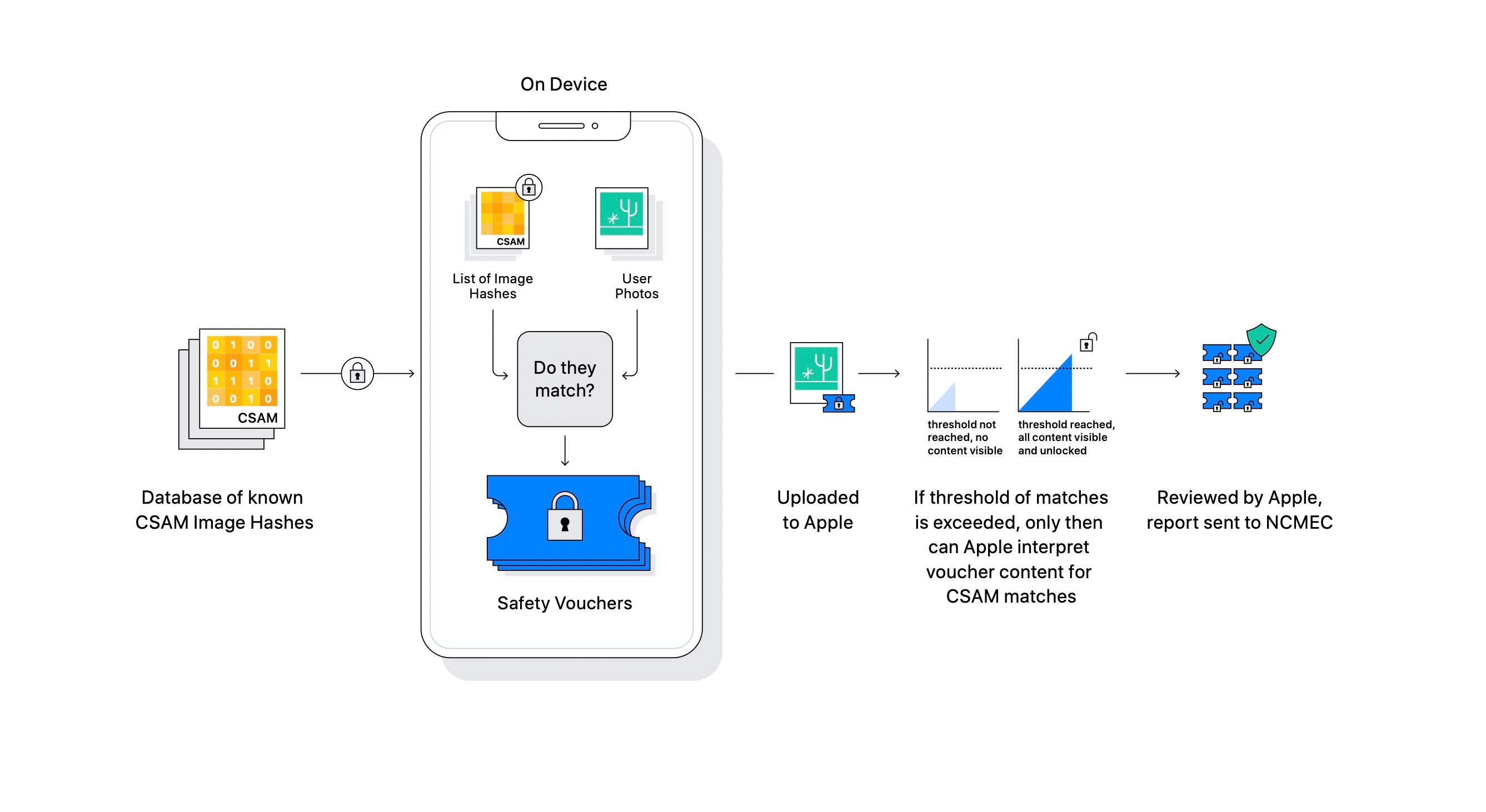

Apple souligne à plusieurs reprises que sa méthode de détection CSAM est conçue en tenant compte de la confidentialité des utilisateurs. En clair, Apple analyse essentiellement les images sur son appareil pour voir s’il existe des correspondances dans une base de données d’images CSAM connues fournies par le National Center for Missing and Exploited Children. Toutes les correspondances sont effectuées sur l’appareil, Apple transformant la base de données du National Center for Missing and Exploited Children en un « ensemble illisible de hachages qui sont stockés en toute sécurité sur les appareils des utilisateurs ».

Apple explique :

Avant qu’une image ne soit stockée dans iCloud Photos, un processus de correspondance sur l’appareil est effectué pour cette image par rapport à l’ensemble illisible de hachages CSAM connus. Ce processus de correspondance est alimenté par une technologie cryptographique appelée intersection d’ensembles privés, qui détermine s’il y a une correspondance sans révéler le résultat. Private Set Intersection (PSI) permet à Apple de savoir si un hachage d’image correspond à des hachages d’image CSAM connus, sans rien apprendre sur les hachages d’image incompatibles. PSI empêche également l’utilisateur de découvrir s’il y avait une correspondance.

S’il y a une correspondance sur l’appareil, l’appareil crée un bon de sécurité cryptographique qui code le résultat de la correspondance. Une technologie appelée partage de secret de frontière est alors employée. Cela garantit que le contenu des bons de sécurité ne peut pas être interprété par Apple, sauf si le compte iCloud Photos dépasse une limite de contenu CSAM connue.

« Par exemple, si un secret est divisé en 1 000 partages et que la limite est de 10, le secret peut être reconstruit à partir de 10 des 1 000 partages. Cependant, si seulement neuf actions sont disponibles, rien ne sera révélé sur le secret », explique Apple.

Apple ne divulgue pas la limite spécifique qu’elle utilisera, c’est-à-dire le nombre de correspondances CSAM requises avant de pouvoir interpréter le contenu des bons de sécurité. Une fois cette limite atteinte, cependant, Apple examinera manuellement le rapport pour confirmer la correspondance, désactiver le compte de l’utilisateur et soumettre un rapport au National Center for Missing and Exploited Children.

La technologie de seuil est importante car elle signifie que les comptes ne sont pas signalés de manière incorrecte. L’examen manuel ajoute également une autre étape de confirmation pour éviter les erreurs, et les utilisateurs pourront faire appel pour rétablir leur compte. Apple affirme que le système a un faible taux d’erreur de moins de 1 sur 1 000 milliards de comptes par an.

Même si tout est fait sur l’appareil, Apple n’analyse que les images stockées dans iCloud Photos. Les images stockées entièrement localement ne sont pas impliquées dans ce processus. Apple affirme que le système sur l’appareil est important et plus respectueux de la confidentialité que l’analyse basée sur le cloud, car il ne signale que les utilisateurs qui ont des images CSAM, plutôt que de numériser constamment les photos de tout le monde dans le cloud.

La mise en œuvre par Apple de cette fonctionnalité est très technique et plus de détails peuvent être obtenus à partir des liens ci-dessous.

Apple dit que la fonctionnalité arrivera en premier aux États-Unis, mais espère se développer ailleurs à l’avenir.

Siri et recherche

Enfin, Apple met à jour Siri et Search :

Apple étend également ses conseils sur Siri et Search, en fournissant des ressources supplémentaires pour aider les enfants et les parents à rester en sécurité en ligne et à obtenir de l’aide dans des situations dangereuses. Par exemple, les utilisateurs qui demandent à Siri comment ils peuvent signaler la CSAM ou l’exploitation d’enfants seront dirigés vers des ressources indiquant où et comment déposer un signalement.

Siri et Search sont également mis à jour pour intervenir lorsque les utilisateurs effectuent des recherches de requêtes liées à CSAM. Ces interventions expliqueront aux utilisateurs que l’intérêt pour ce sujet est nuisible et problématique, et fourniront des ressources partenaires pour les aider sur ce sujet.

Des mises à jour pour Siri et Search arriveront plus tard cette année dans une mise à jour pour iOS 15, iPadOS 15, watchOS 8 et macOS Monterey.

Témoignages

John Clark, président et chef de la direction, Centre national pour les enfants disparus et exploités : « La protection étendue des enfants d’Apple change la donne. Avec autant de personnes utilisant des produits Apple, ces nouvelles mesures de sécurité ont le potentiel de sauver des vies pour les enfants qui sont attirés en ligne et dont les images horribles circulent dans le matériel pédopornographique. Au Centre national pour les enfants disparus et exploités, nous savons que ce crime ne peut être combattu que si nous sommes déterminés à protéger les enfants. Nous ne pouvons le faire que parce que des partenaires technologiques comme Apple s’expriment et montrent leur dévouement. La réalité est que la vie privée et la protection des enfants peuvent coexister. Nous applaudissons Apple et sommes impatients de travailler ensemble pour faire de ce monde un endroit plus sûr pour les enfants. »

Julie Cordua, PDG, Thorn : « Chez Thorn, nous croyons au droit à la vie privée en ligne, y compris pour les enfants dont les abus sexuels sont enregistrés et diffusés sur Internet sans consentement. L’engagement d’Apple à déployer des solutions technologiques qui équilibrent le besoin de confidentialité et de sécurité numérique pour les enfants nous rapproche un peu plus de la justice pour les survivants dont les moments les plus traumatisants sont diffusés en ligne ; un pas de plus vers un monde où chaque plate-forme numérique avec un bouton de téléchargement s’engage à une détection CSAM proactive dans chaque environnement ; et un pas de plus vers un monde où chaque enfant a la possibilité d’être simplement un enfant. »

Stephen Balkam, fondateur et PDG, Family Online Safety Institute : « Nous soutenons l’évolution continue de l’approche d’Apple en matière de sécurité des enfants en ligne. Compte tenu des défis auxquels les parents sont confrontés pour protéger leurs enfants en ligne, il est impératif que les entreprises technologiques réitèrent et améliorent continuellement leurs outils de sécurité pour répondre aux nouveaux risques et aux préjudices réels. »

Ancien procureur général Eric Holder : « L’augmentation historique de la prolifération du matériel en ligne sur les abus sexuels sur enfants est un défi qui doit être relevé avec l’innovation des technologues. Les nouveaux efforts d’Apple pour détecter le CSAM représentent une étape importante, démontrant que la sécurité des enfants ne doit pas se faire au détriment de la vie privée et est un autre exemple de l’engagement de longue date d’Apple à rendre le monde meilleur en protégeant constamment la vie privée des consommateurs. »

L’ancien procureur général adjoint George Terwilliger : « Les publicités d’Apple représentent une étape très importante et bienvenue pour responsabiliser les parents et aider les organismes chargés de l’application de la loi dans leurs efforts pour prévenir les préjudices causés aux enfants par les fournisseurs de CSAM. Grâce aux efforts accrus d’Apple en matière de détection et de signalement de CSAM, les autorités chargées de l’application des lois seront en mesure de mieux identifier et arrêter les personnes de notre société qui représentent la plus grande menace pour nos enfants. »

Benny Pinkas, professeur au département d’informatique de l’université Bar Ilan : « Le système PSI d’Apple offre un excellent équilibre entre confidentialité et utilité et sera extrêmement utile pour identifier le contenu CSAM tout en maintenant un niveau élevé de confidentialité des utilisateurs et en minimisant les faux positifs. »

Mihir Bellare, professeur, Département d’informatique et d’ingénierie, UC San Diego : « Prendre des mesures pour limiter la CSAM est une étape louable. Mais sa mise en œuvre nécessite un certain soin. Fait naïvement, cela nécessite de numériser les photos de tous les utilisateurs d’iCloud. Mais nos photos sont personnelles, enregistrant des événements, des moments et des personnes dans nos vies. Les utilisateurs attendent et veulent qu’ils restent privés d’Apple. A l’inverse, la base de données photo du CSAM ne doit pas être rendue publique ou connue de l’utilisateur. Apple a trouvé un moyen de détecter et de signaler les contrevenants CSAM tout en respectant ces restrictions de confidentialité. »

David Forsyth, président de l’informatique à l’Université de l’Illinois à l’Urbana-Champagne College of Engineering : « L’approche d’Apple préserve la confidentialité mieux que tout ce que je connais […] À mon avis, ce système augmentera probablement considérablement la probabilité que les personnes possédant ou voyageant en [CSAM] sont trouvés; cela devrait aider à protéger les enfants. Les utilisateurs inoffensifs devraient subir une perte de confidentialité minimale ou nulle, car les dérivés visuels ne sont révélés que s’il y a suffisamment de correspondances pour les images CSAM et uniquement pour les images qui correspondent aux images CSAM connues. La précision du système d’appariement, combinée au seuil, rend très improbable la révélation d’images qui ne sont pas des images CSAM connues. «

FTC : Nous utilisons des liens d’affiliation pour les automobiles génératrices de revenus. Suite.

Découvrez . sur YouTube pour plus d’actualités Apple :

Commentaires

Laisser un commentaire